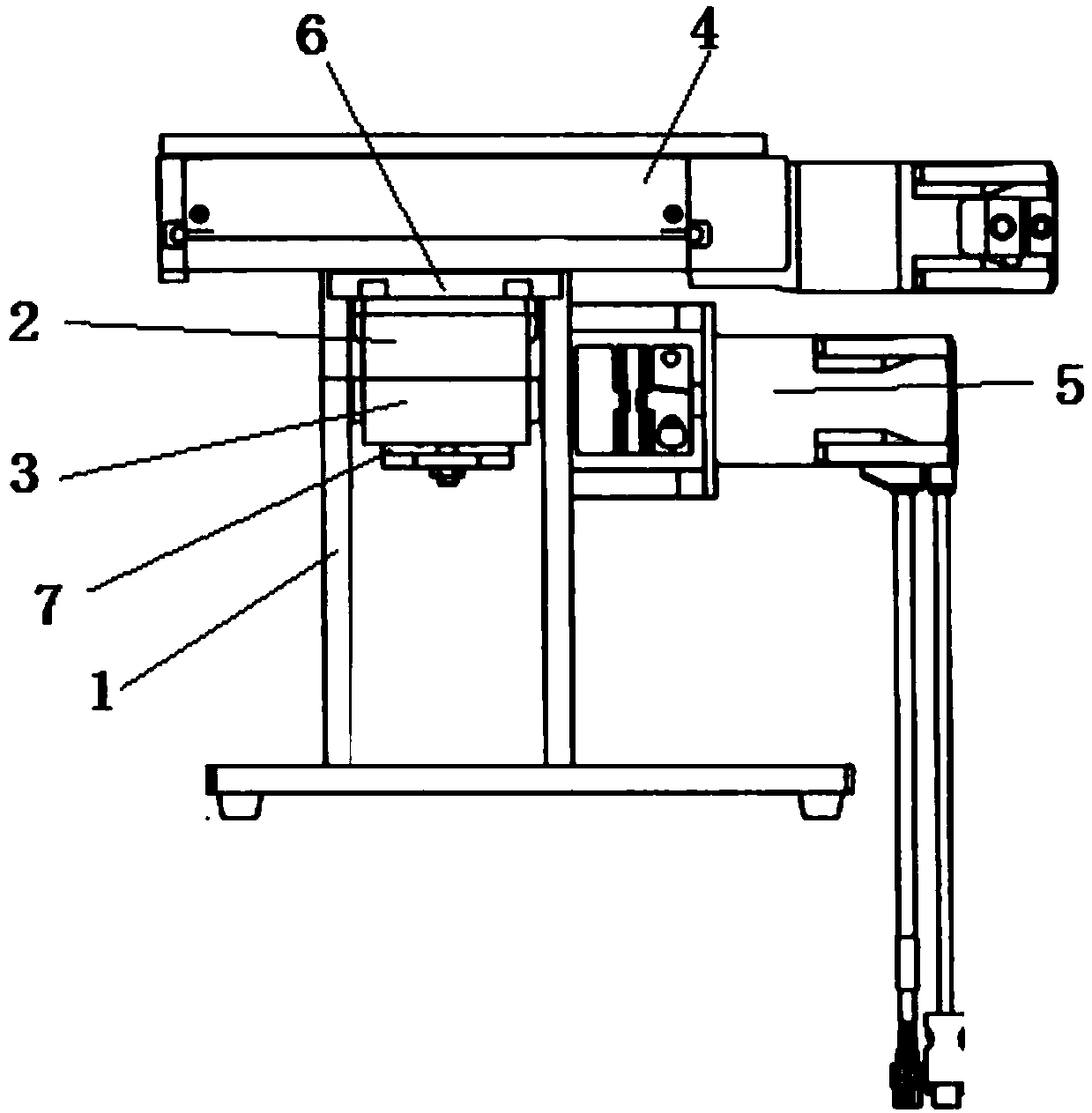

本实用新型公开了一种仿真口腔加工机器人及其控制方法,包括一支座、控制器及仿真的人体上颚和人体下颚;仿真人体上颚与设置于支座上的第一驱动装置固定连接,仿真人体下颚与设置于支座上的第二驱动装置固定连接,控制器分别与第一驱动装置、第二驱动装置电性连接,用于程序控制第一驱动装置和第二驱动装置的协同动作;第一驱动装置用于驱动仿真人体上颚做直线往复研磨运动,第二驱动装置用于驱动仿真人体下颚做旋转运动,控制仿真人体下颚与上颚间的开合。本实用新型通过第一驱动装置和第二驱动装置的交替配合,使仿真上下颚的相对运动仿照了人体咀嚼时的下颚动作,实现了高度仿真人体在咀嚼时的咀嚼动作,准确模拟食物在口腔加工中的过程,为利用体外消化系统模拟人体消化和测量食物的消化吸收提供准确数据。

本发明实施例提供的一种基于城市智慧体育的并行融合网络的姿态识别方法和装置,该方法采用全新的奥斯瓦德网络对输入的预处理图像进行特征提取,对从高到低不同分辨率的图像进行特征提取,在整个过程中都保持高分辨率和低分辨率特征相融合后进行预测。本发明进行了多次多尺度融合,使得每一个高分辨率到低分辨率的表征都从其他并行表示中反复接收信息,从而得到丰富的高分辨率表征。因此,预测的关键点更准确,在空间上也更精确。

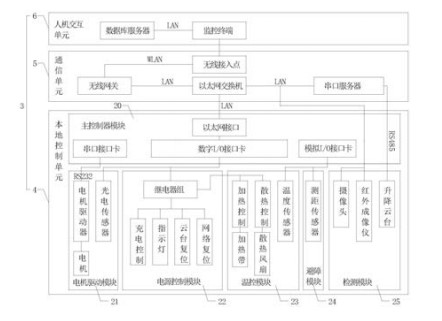

本发明提供电力设备智能巡检机器人,包括轨道总成、轨道机器人和上位机控制系统,所述轨道机器人滑动设置在所述轨道总成上,所述上位机控制系统包括本地控制单元、通信单元和人机交互单元,所述本地控制单元用于向所述轨道机器人下达各项操作指令,所述通信单元用于实现所述本地控制单元和所述人机交互单元之间的数据互通,所述人机交互单元用于实现所述轨道机器人的远端控制。本发明能够能够实现轨道机器人状态、装置信号等运行状况信息的实时采集与智能分析,还能监测温度、湿度等环境质量因素,满足电力设备的巡检作业。

本发明涉及一种低成本高负载的植保专用无人机及驱动方法,包括安装在机架上的飞行机构、姿态控制机构和喷药系统。所述的飞行机构为无人机的起飞,降落和调整飞行高度提供动力输出。所述的姿态调整机构是调整无人机的航向和飞行姿态,确保无人机在预定的作业路线上。所述的喷药系统控制植保无人机到达预定的作业区域时喷药系统开始喷药作业。本发明采用发动机驱动的横列式反转双旋翼,提供无人机高度方向的升力,具有负载能力高,作业时间长、工作效率高;采用两对电动小旋翼,提供无人机水平方向姿态调整和作业飞行所需的推力,使无人机在三维空间的驱动是完全解耦的,具有结构和控制原理简单,维修方便,同时遥控操作简单易学,使用和维护成本低等优点。

本发明提供一种遥操作机器人基于视觉的动觉示教控制方法,其步骤包括采用立体视觉技术对现场的作业对象及背景环境(障碍物)进行识别与空间信息提取;以通过视觉识别、计算出的作业对象与机器人末端间的位姿关系为参数,构建作业对象对机器人的虚拟吸引力;以机器人末端沿其速度方向与背景环境(障碍物)的距离为参数,构建机器人所受的障碍物排斥力;将作业对象虚拟吸引力、障碍物虚拟斥力以及机器人抓取物体时的真实作用力合成机器人示教力;通过主端系统与从端系统间的雅可比矩阵,将示教力向操作手柄反馈,从而实现对操作者的动觉示教。本发明相对于现有技术具有如下的优点及技术效果 :[0031] 1. 将机器智能与人类高级决策的优点有机集成,可有效提高机器人的作业效率与局部自主。[0032] 2. 降低对操作人员熟练程度的要求。[0033] 3. 对可能发生的机器人与环境间的碰撞进行预测,可有效保证机器人作业系统的安全性。[0034] 4. 能够缓解操作者控制机器人时的心理紧张及决策疲劳。[0035] 5. 控制回路具有数据量小、信息丰富、超前预测的优点,可有效避免图像时滞导致的机器人操控盲目性。一种遥操纵机器人基于视觉的动觉示教控制方法,其特征在于,包括以下步骤 :[0007] S1、采用立体视觉技术对现场的作业对象及背景环境 ( 障碍物 ) 进行识别与空间信息提取;[0008] S2、以步骤 S1 中获取的作业对象与机器人末端间的位姿关系为参数,构建作业对象对机器人的虚拟吸引力;[0009] S3、以步骤 S1 中获取的机器人末端沿其速度方向与背景环境 ( 障碍物 ) 的距离为参数,构建机器人所受的障碍物排斥力;[0010] S4、将作业对象虚拟吸引力、障碍物虚拟斥力以及机器人抓取物体时的真实作用力合成机器人示教力;[0011] S5、通过主端系统与从端系统间的雅可比矩阵,将示教力向操作手柄反馈,从而实现对操作者的动觉示教。[0012] 根据权利要求 1 所述的遥操纵机器人基于视觉的动觉示教控制方法,其特征在于,所述步骤 S1 包括 :包括以下步骤 :[0013] S11.1、将 Bumblebee 双目摄像头采用 eye-to-hand 方式固定在现场环境正上方,光轴与地面垂直,简称为环境相机;[0014] S11.2、根据环境相机图像中各像素点的颜色、灰度或纹理特征,从中剔除机器人区域及作业对象区域,以获得背景图像;[0015] S11.3、根据图像匹配及摄像机标定的结果,实时计算背景图像中各像素点的空间坐标;[0016] S11.4、采用基于空间自相关性的内插方式来预测估计所剔除的机器人区域及作业对象区域应有像素属性,并结合背景图像像素特征,生成背景环境的高程数据模型;[0017] S12.1、将 Kinect 相机采用 eye-in-hand 方式固连于机器人末端,简称为手部相机;[0018] S12.2、根据手部相机图像中各像素点的颜色、纹理特征,采用结合人口统计与区域增长的图像分割方法来提取作业对象区域,并采用分裂 - 合并算法提取该区域轮廓的近似多边形,取多边形的顶点为作业对象图像特征;[0019] S12.3、根据图像匹配及摄像机标定的结果,实时计算作业对象区域各像素点的空间坐标,并构建其 OBB(Oriented Bounding Box- 有向包围盒 ) 包围盒模型。

本发明提出一种无人机的可视导航系统。其中,无人机集群的协作交互方法包括以下步骤:无人机集群中的某个无人机确定其通信覆盖范围内满足协作条件的无人机,并根据满足协作条件的无人机建立无人机协作组;确定所述无人机协作组中的多架无人机的机间路由;根据所述机间路由的链路状态信息对所述无人机协作组中的多架无人机分配协作任务;根据所述无人机协作组中的多架无人机的运动状态评估所述链路状态,并根据评估结果更新所述无人机协作组的无人机及每架无人机的协作任务。本发明可靠性强,通信质量高,能较好地适应可视导航中的无人机集群通信环境。

一种基于主动全景视觉传感器的机器人视觉系统,包括全方位视觉传感器、关键面激光光源以及用于对全方位图像进行三维立体摄像测量、障碍物检测、避障和导航的微处理器,所述全方位视觉传感器与所述关键面激光光源配置在同一根轴心线上。

本发明公开了一种基于VR-Forces仿真平台的多无人机协同任务规划仿真系统,其特征是:多无人机协同任务规划仿真系统由n个无人机仿真子系统、一个地面控制中心仿真子系统和一个任务规划仿真场景管理子系统组成。